_logo.png)

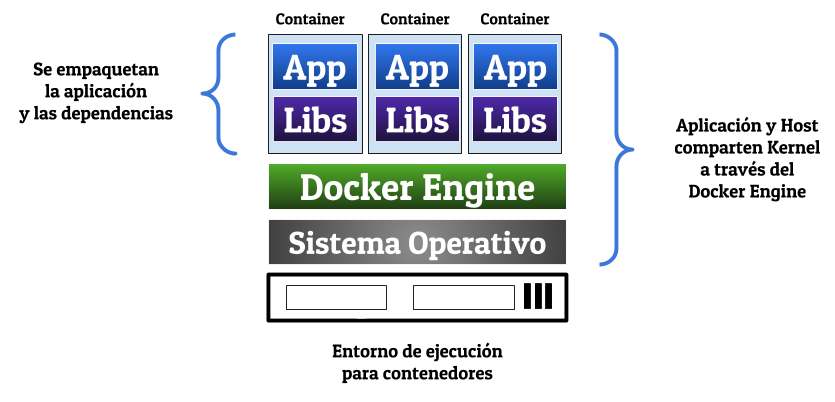

Si tuviéramos que definir Docker de una manera rápida y poco formal diríamos lo siguiente:

Docker es una

tecnología de virtualización "ligera" cuyo

elemento básico es la utilización de

contenedores en vez de máquinas virtuales y cuyo

objetivo principal es el despliegue de

aplicaciones encapsuladas en dichos

contenedores.

Dicho de esta manera puede parecer que no es más que otra tecnología de virtualización, pero para entender mejor cómo ha surgido esta tecnología y comprender las ventajas que aporta debemos echar un poco la vista atrás y conocer la evolución en el despliegue de aplicaciones.

En esa evolución nos podemos encontrar, de manera general y simplificada, con tres grandes pasos:

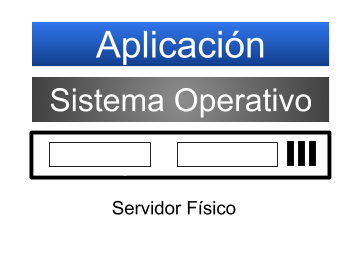

- Arquitectura de un único servidor

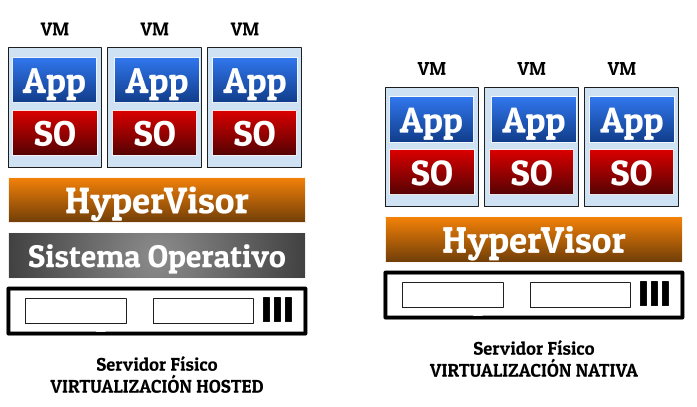

- Virtualización

- Contenedores

A continuación describiremos estos tres pasos haciendo especial hincapié en sus ventajas e inconvenientes.